|

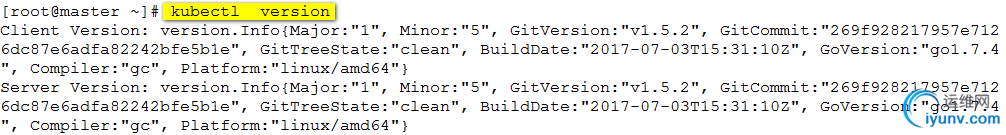

基于Centos7构建Kubernetes平台 一、实验环境 3台centos7的主机:

master 192.168.111.131部署etcd,kube-apiserver,kube-controller-manager,kube-scheduler 4个应用。

node01 192.168.111.130 部署docker,kubelet, kube-proxy 3个应用

node02 192.168.111.129 部署docker,kubelet, kube-proxy 3个应用

二、实验步骤

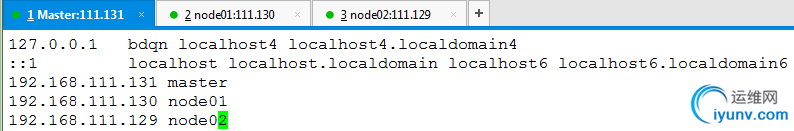

1. 修改主机名和ip,三个主机网卡均设置为桥接模式,能够联网。 2. 分别修改/etc/hosts文件: Master配置

#vim /etc/hosts

Node01

Node01

#scp root@192.168.111.128:/etc/hosts /etc/

Node02

#scp root@192.168.111.128:/etc/hosts /etc/

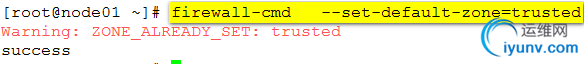

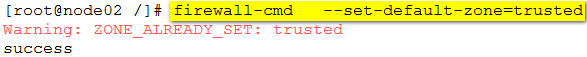

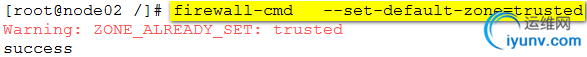

3. 三台均设置防火墙的默认区域为trusted。

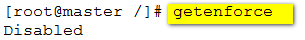

4. 三台均关闭selinux.

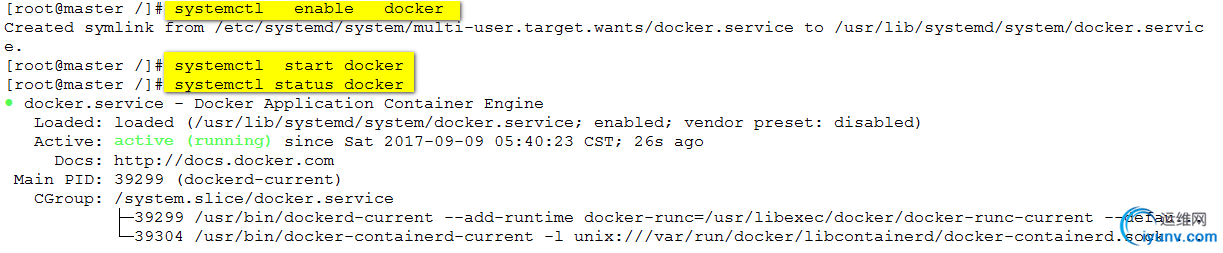

5. 安装docker,并启动。因为master之后还需要做registry仓库,所以也需要安装docker.

#yum install -y docker

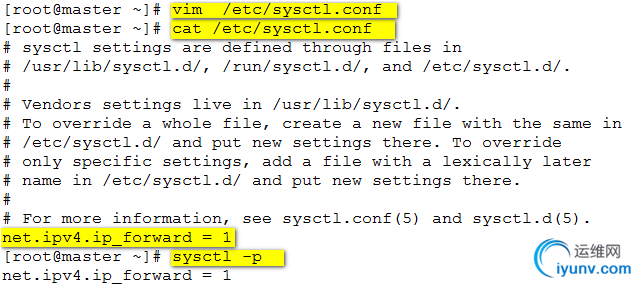

6. 开启路由转发功能:

6. 开启路由转发功能:

7、实现node01和node02之间容器互通。

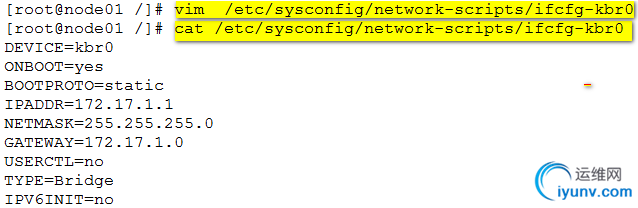

1)node01和node02新建网桥,并固定网桥ip。

node01上操作: 删除网桥docker0,新建网桥kbr0:

新建网桥的配置文件:

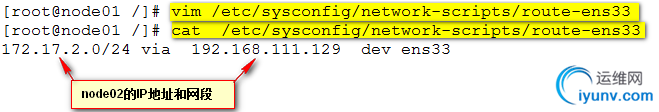

新建路由文件:route-eth0,eth0为node1上的网卡名。

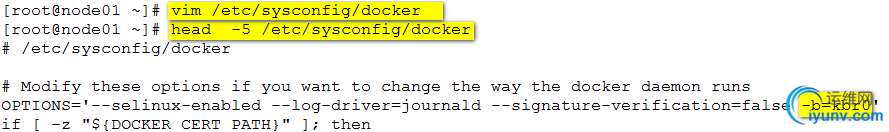

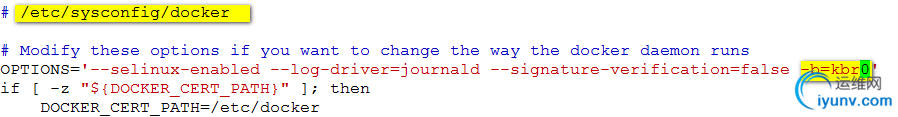

修改docker配置文件,添加-b=kbr0参数

reboot重启系统使网桥设置生效。

reboot重启系统使网桥设置生效。

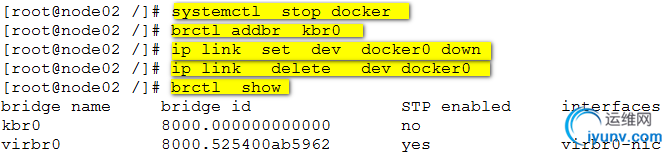

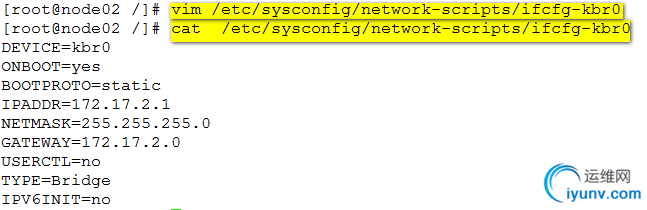

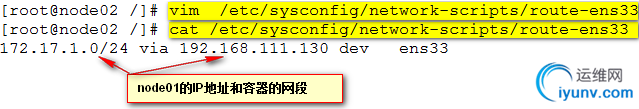

2)对node02做同样的设置:

新建网桥:

新建网桥配置文件: #scp root@192.168.111.129:/etc/sysconfig/network-scripts/ifcfg-kbr0 /etc/sysconfig/network-scripts/

创建路由文件:

修改docker 配置文件: #vim /etc/sysconfig/docker

重启系统reboot.

重启系统reboot.

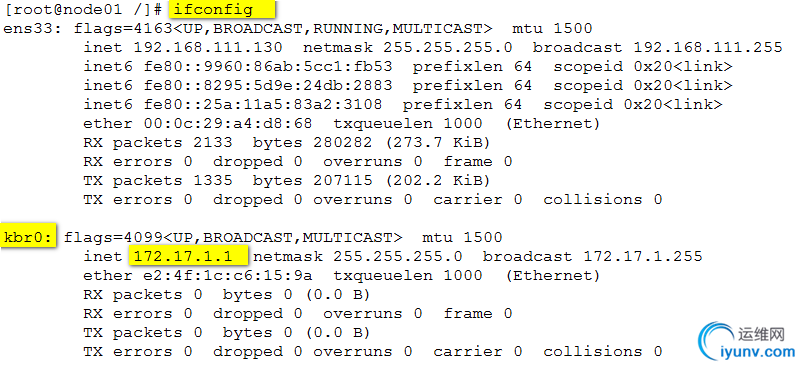

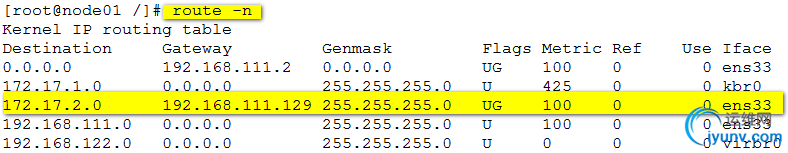

3)系统启动之后,查看网卡信息和路由信息。

#ifconfig

4)验证两个宿主机间容器的互通性:

4)验证两个宿主机间容器的互通性:

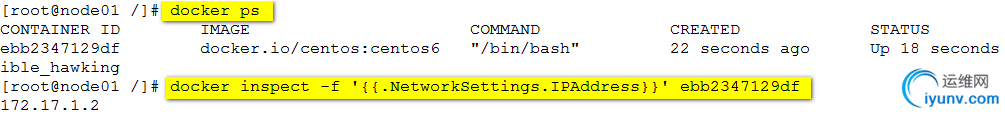

node01上运行一个容器:

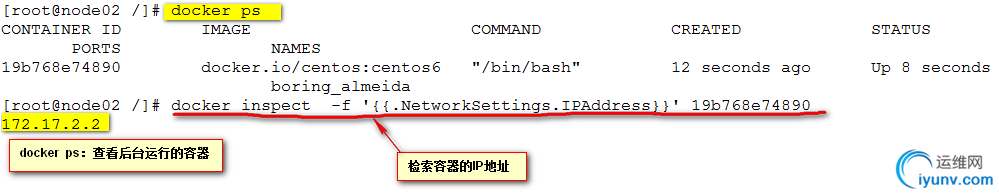

node02上运行一个容器:

node02上运行一个容器:

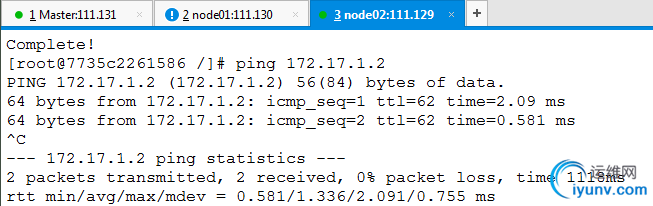

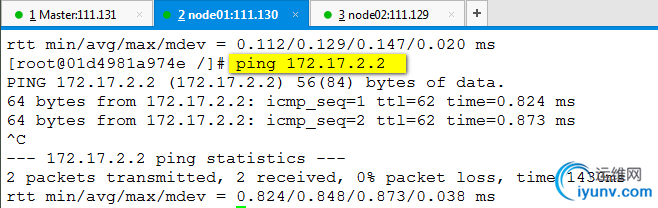

容器间互ping:

容器间互ping:

#docker run -it docker.io/centos:centos6

# yum install -y iputils 进入容器安装

#dcoker run -it docker.io/centos:centos6

master上部署应用:

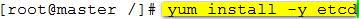

1、安装etcd.

查看etcd配置文件:

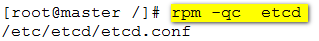

2、修改配置文件:

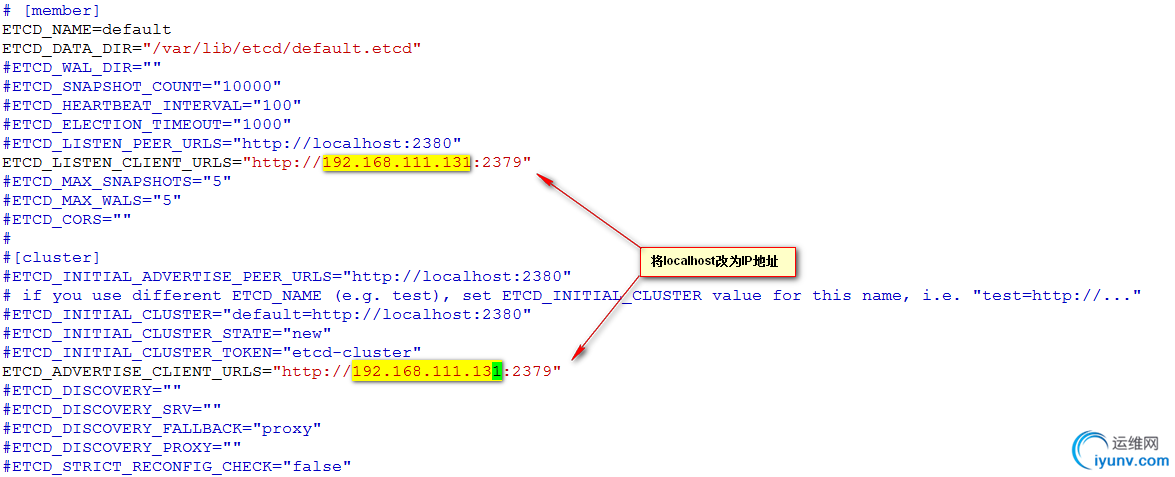

3、启动etcd服务:

3、启动etcd服务:

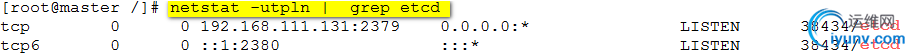

查看服务端口号:

查看服务端口号:

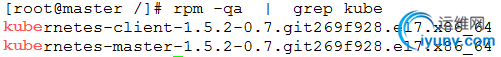

4、部署k8s-master组件(apiserver+controller-manager+scheduler)

4、部署k8s-master组件(apiserver+controller-manager+scheduler)

安装软件: #yum install -y kubernetes-master

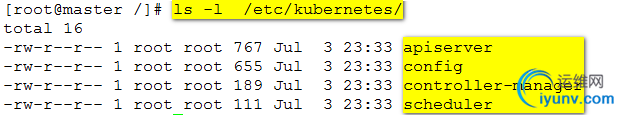

查看配置文件:

5、修改配置文件:

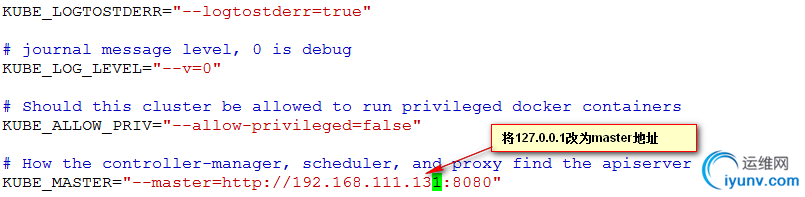

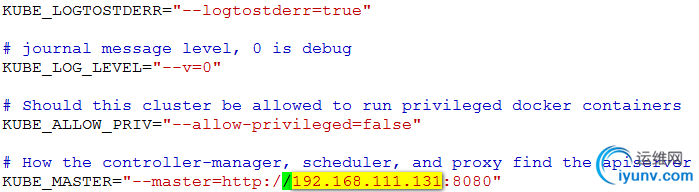

#vim /etc/kubernetes/config

解释:

解释:

KUBE_LOGTOSTDERR 日志设置

KUBE_LOG_KEVEL 日志级别设置

KUBE_ALLOW_PRIV 是否允许运行特权容器

KUBE_MASTER 主节点的地址,主要为replication controller和scheduler及kubelet可以顺利找到apiserver

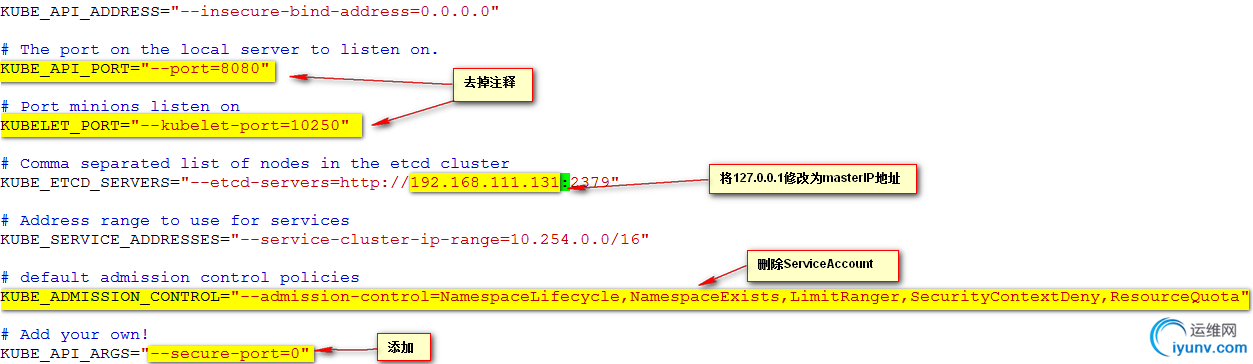

#vim /etc/kubernetes/apiserver

KUBE_API_ADDRESS 监听的接口,如果配置为127.0.0.1则只监听localhost,配置为0.0.0.0会监听所有接口,这里配置为0.0.0.0。

KUBE_API_ADDRESS 监听的接口,如果配置为127.0.0.1则只监听localhost,配置为0.0.0.0会监听所有接口,这里配置为0.0.0.0。

KUBE_API_PORT="--port=8080" apiserver的监听端口,默认8080,不用修改。

KUBELET_PORT="--kubelet_port=10250" kubelet监听的端口,默认10250,无需修改

KUBE_ETCD_SERVERS //指定etcd节点的地址

KUBE_SERVICE_ADDRESSES 这个是设置今后运行Service所在的ip网段

KUBE_API_ARGS=”--secure-port=0” 默认是要求https安全通信,”--secure-port=0”则不要求https安全通信

注:这里需要注意原来KUBE_ADMISSION_CONTROL默认包含的要删掉,不然启动API server的时候会报错

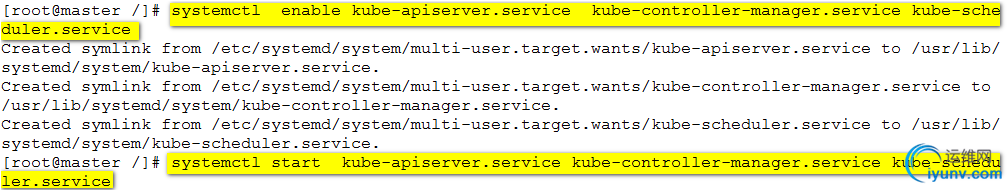

6、启动服务:

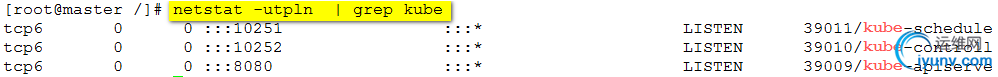

查看服务端口:

部署node主机:

部署node主机:

1、安装kubernetes-node软件:

#yum install -y kubernetes-node

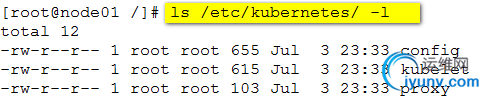

2、修改配置文件:

#vim /etc/kubernetes/config

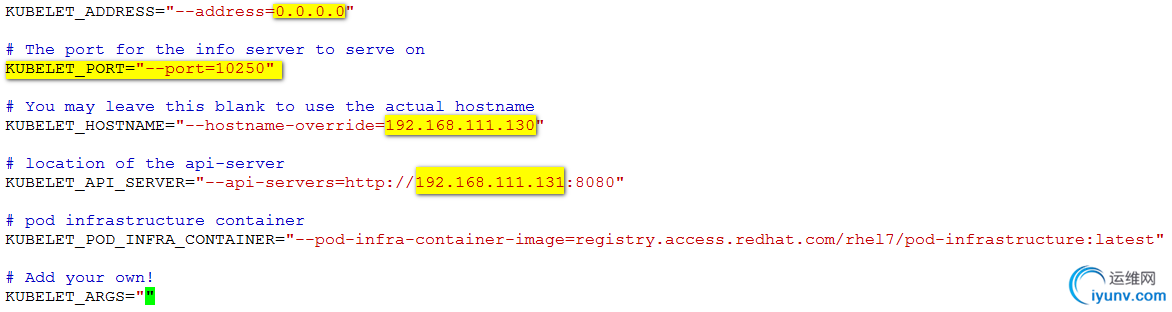

#vim /etc/kubernetes/kubelet

配置项KUBELET_POD_INFRA_CONTAINER="--pod-infra-container-image=registry.access.redhat.com/rhel7/pod-infrastructure:latest"作用k8s创建pod的时候需要起一个基本容器,所以node节点要能连网。也可以自己搭建一个私有仓库,将pod-infrastructure:latest镜像上传到私有仓库中,修改此配置文件的地址就可以。

配置项KUBELET_POD_INFRA_CONTAINER="--pod-infra-container-image=registry.access.redhat.com/rhel7/pod-infrastructure:latest"作用k8s创建pod的时候需要起一个基本容器,所以node节点要能连网。也可以自己搭建一个私有仓库,将pod-infrastructure:latest镜像上传到私有仓库中,修改此配置文件的地址就可以。

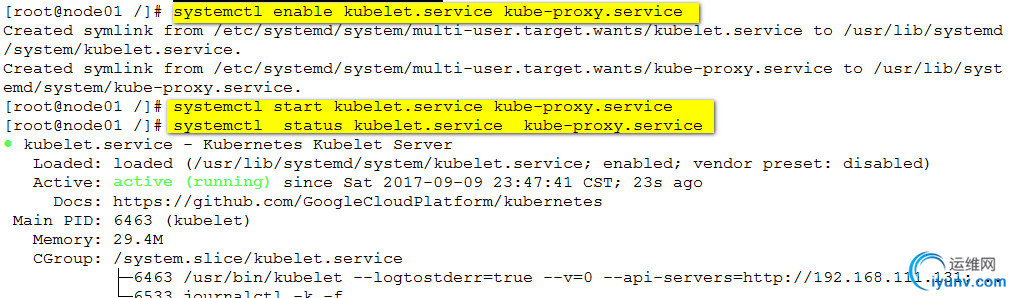

3、启动服务:

4、在node02主机上重复上面的操作。

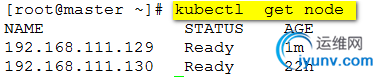

5、在master上检查node 状态:

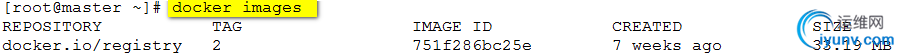

建私有仓库:

建私有仓库:

Kubernetes管理容器如果是第一次操作,可能会有一定的等待时间,这是因为第一次下载images需要一段时间。如果本地没有docker registry,要确保节点能访问互联网,所以我们可以搭建一个私有仓库,由私有仓库提供所需要的镜像, 本实验环境中用kubernetes同时作为registry。 1、导入镜像:

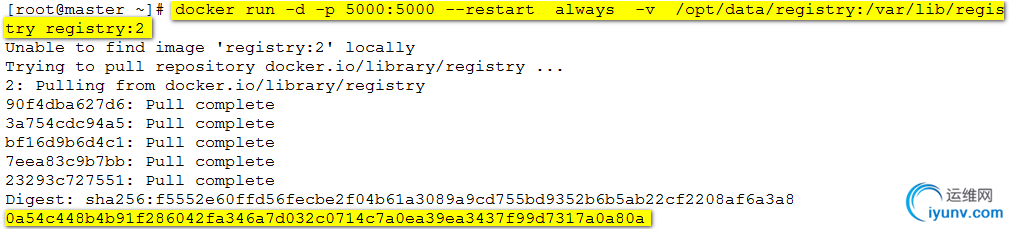

2、基于私有仓库镜像运行容器

2、基于私有仓库镜像运行容器

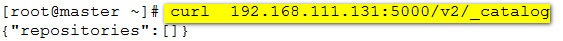

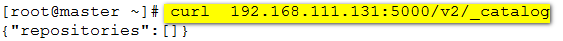

3、本地访问私有仓库:

3、本地访问私有仓库:

4、上传镜像到私有仓库。

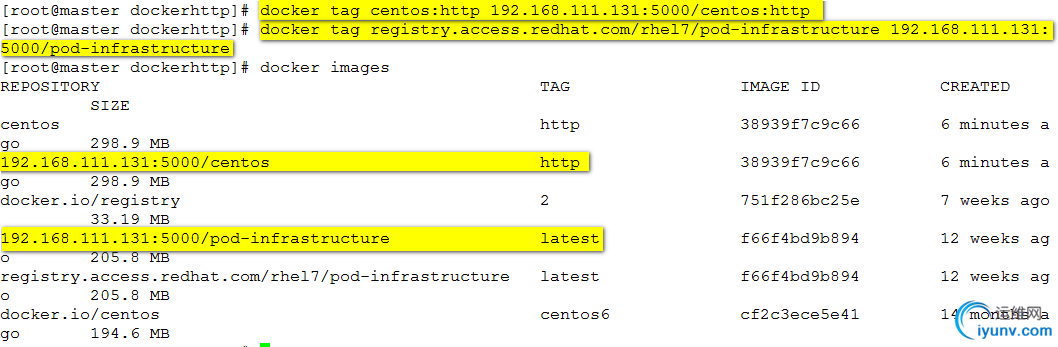

导入之后用到的镜像到本地

给基础镜像打个标签:

给基础镜像打个标签:

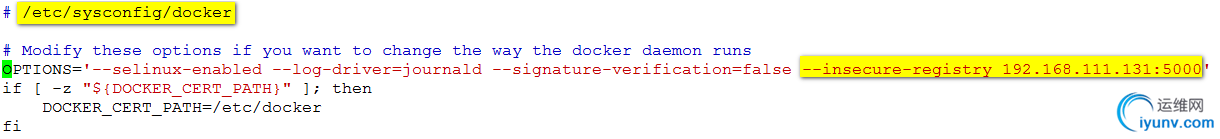

在三台主机上均修改docker 的配置文件,指定私有仓库的url.

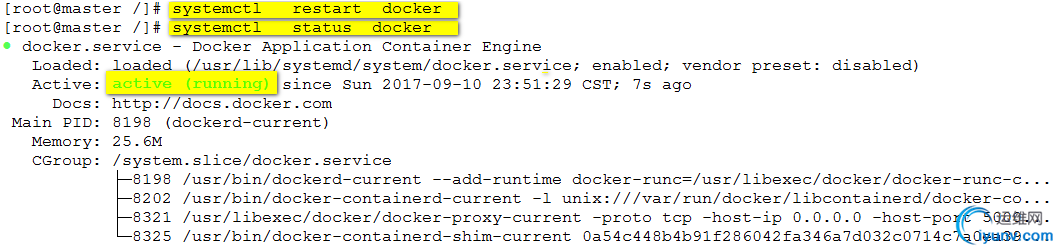

重启docker服务:

重启docker服务:

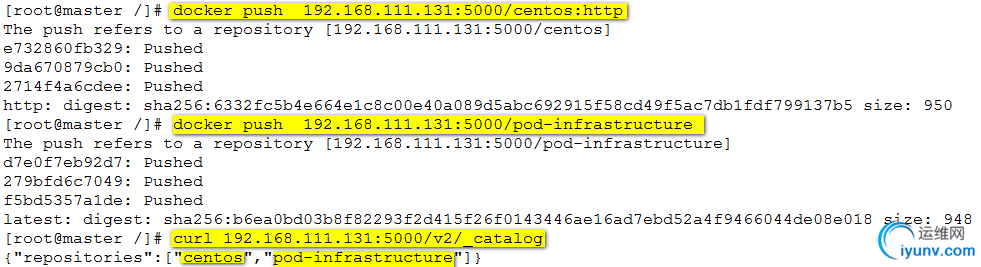

上传镜像到私有仓库并查看:

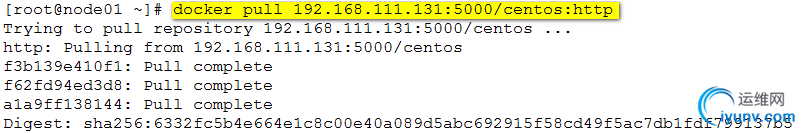

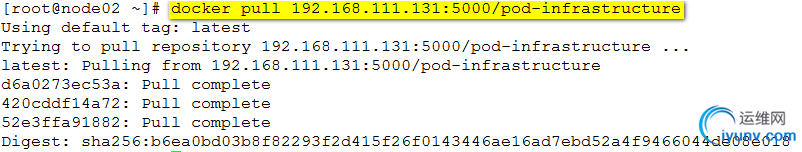

测试,下载刚才上传的镜像:

测试,下载刚才上传的镜像:

部署web应用

部署web应用

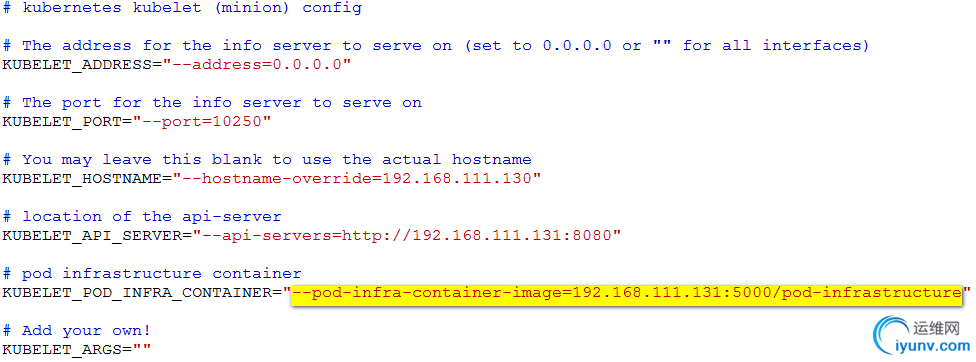

1、为了部署pod的时候,下载镜像速度快点,把node节点主机配置文件中的pod镜像下载地址修改为本地私有仓库地址:

#vim /etc/kubernetes/kubelet

#systemctl restart kubelet.service

#systemctl restart kubelet.service

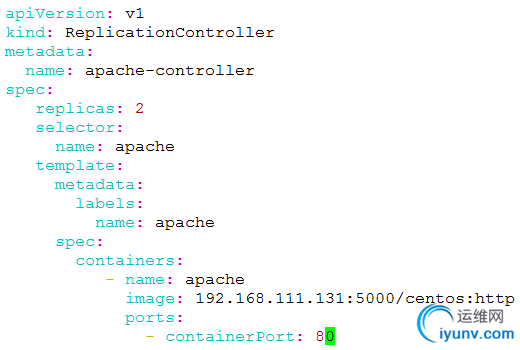

2、创建apache-rc.yaml文件,根据文件内容创建rc和pod。

注意:必须按照此格式编写否则会报错

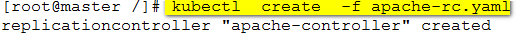

#kubectl create -f apache-rc.yaml

error: error validating "apache-rc.yaml": error validating data: found invalid field spec for v1.ReplicationControllerSpec; if you choose to ignore these errors, turn validation off with --validate=false

查看pods状态:

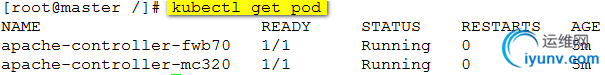

查看pods详细状态:

附:删除pod

附:删除pod

kubectl delete pod podName

由于设置了两份副本,所以删除pod的时候,k8s会迅速起另外一个一模一样的pod以保持副本数量为2不变。

要彻底删除pod,只能删除创建它的replication controller

查看replication controller

kubectl get rc

删除replication controller

kubectl delete rc rcName

删除rc之后,其创建的pod会一并删除

3、部署节点内部可访问的apache service

Server的type有ClusterIP和 NodePort之分,缺省是ClusterIp,这种类型的service只能在集群内部访问

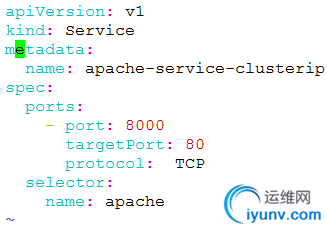

创建配置文件:

#vim apache-service-clusterip.yaml

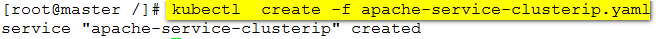

创建service:

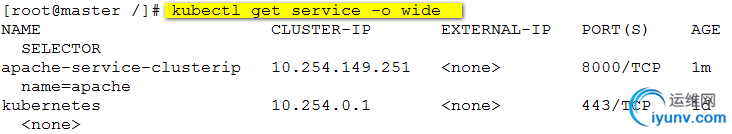

查看service状态:

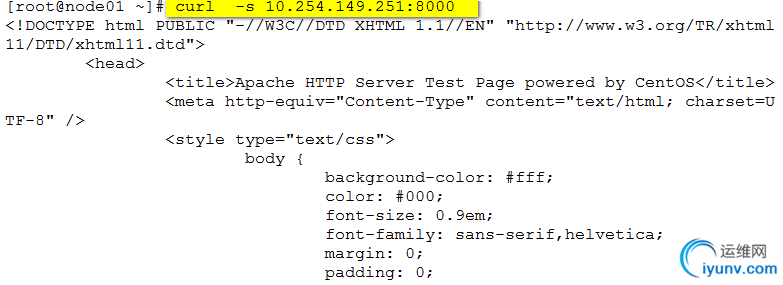

验证apache服务:(在node节点执行)

4、部署外部可访问的apache service。

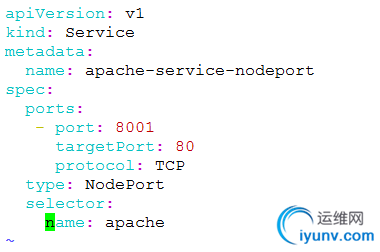

创建nodeport类型的service . 这种类型的Service在集群外部是可以访问 #vim apache-nodeport-service.yaml

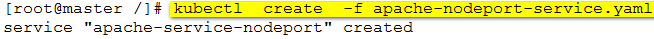

创建service:

查看service:

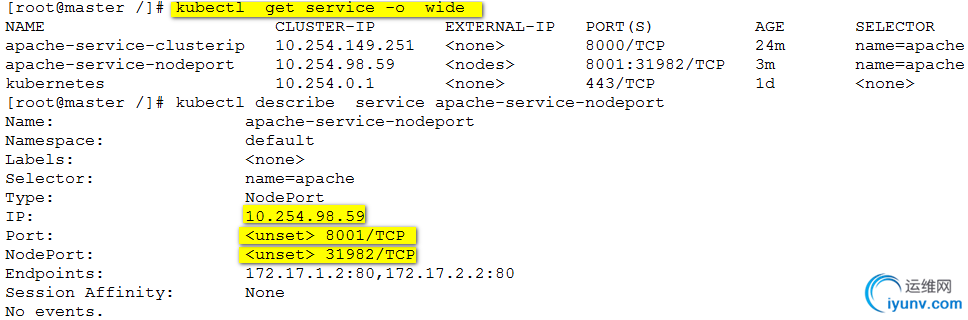

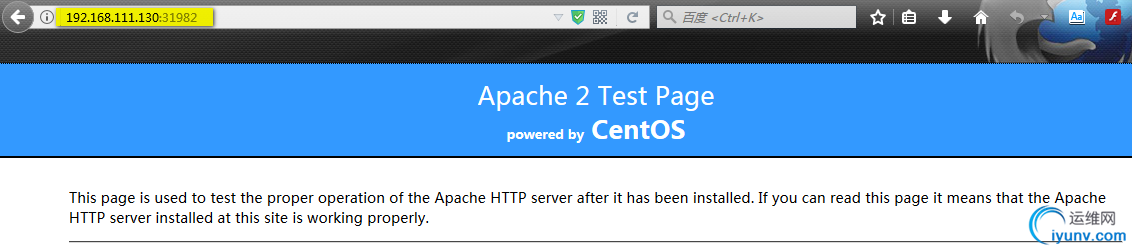

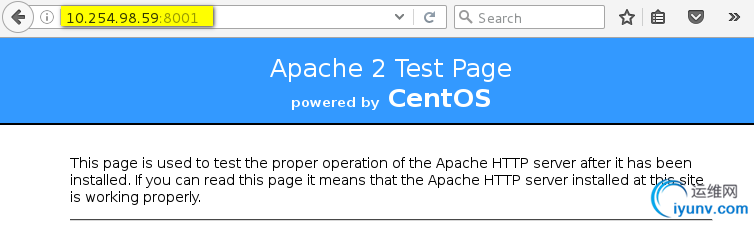

验证service的可访问性:

验证service的可访问性:

外部访问:

内部访问:

到此为止kubernetes 集群搭建完毕!!!

到此为止kubernetes 集群搭建完毕!!!

|