|

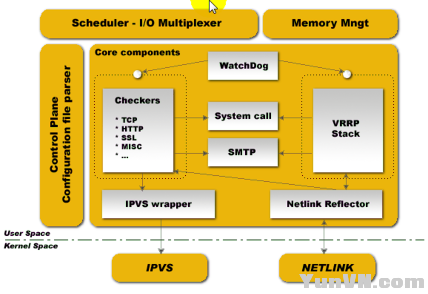

Keepalived是为了实现LVS(持久连接)高可用而应运而生的一款独具特色的软件,以其独特的使用方式受到广大爱好者的追捧,下边我本就详细讲解一下其内容。 Keepalived简介 正如开头所说,keepalived主要是为了实现LVS的高可用而产生的,为此他实现了如下三个功能:ip地址转移、LVS规则转移和后端服务器健康状况检测。我们来一一分析。 VRRP协议 Keepalived如何实现ip地址转移的功能呢?这里就不得不提到VRRP协议(虚拟路由冗余协议)了,它是一种为了解决网络高可用的实现机制,它能实现路由网关地址的漂移,以解决网关损坏而带来的网络故障。而keepalived的ip地址转移功能正是通过软件的方式模拟了VRRP协议的实现,其工作示意图如下:

图1

一旦master出现故障,VRRP会根据优先级的高低在多个路由上选择master,并尝试重新获取原来master信息,如果在规定时间段内没有应答,新的网关将漂移到新master上。而多个路由之间则通过互传在线信息以确保自己的状态,一旦发现没有信息,在等待一定时间段后便可顶替成为master。这就是VRRP的工作流程。它还有很多的定义,如: 备份组:将多个网关设备组成一个虚拟设备,这个虚拟设备就叫备份组 角色:分为主设备和从设备,与其优先级有关。只能有一个主,可以有多个从。等 双主模型:使多台设备互为主从关系来实现其功能。 这些都能在官方文档中找到,就不在多讲了。主要在于keepalived正是借助于这个协议,运用内部模块虚拟出其功能,来实现ip地址转移功能。 LVS规则转移和后端服务器健康状况检测 Keepalived的另外两个功能则是通过内部机制来模拟实现的,我们将在后边的实现配置下详细讲解,这里就不罗嗦了。要注意的是,根据LVS的特性,keepalived分为主从模型和双主模型。 Keepalived的作用说到其作用,我们就不得不先看一张图,如下:

图2 官方工作模型 从图上我们不难看出,keepalived设计的最初目的就是为了实现LVS的高可用。但是我们知道如果要实现其高可用我们还可以用corosync等来实现,为什么要用keepalived呢?因为其使用简单,所以深受大家喜欢。另外它还用作RealServer的健康状态检查以及LoadBalance主机和BackUP主机之间failover的实现。高可用web架构:LVS+keepalived+nginx+apache+php+eaccelerator

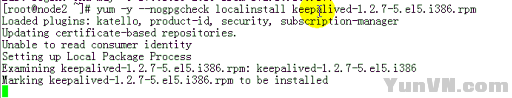

Keepalived实现和配置Keepalived的实现依赖于其配置文件和诸多的脚本,其不同模型的配置不同,下边我们用Keepalived+HAProxy配置高可用负载均衡: 1、在节点上安装keepalived。

2、查看主从模型的配置文件;cat /etc/keepalived/keepalived.conf 格式如下: ! Configuration File for keepalived

global_defs { notification_email { linuxedu@foxmail.com mageedu@126.com } notification_email_from root@db.com smtp_connect_timeout 3 smtp_server 127.0.0.1 router_id LVS_DEVEL }

vrrp_script chk_haproxy { script "killall -0 haproxy" interval 1 weight 2 }

vrrp_script chk_mantaince_down { script "[[ -f /etc/keepalived/down ]] && exit 1 || exit0" interval1 weight 2 }

vrrp_instance VI_1 { interface eth0 state MASTER # BACKUP for slaverouters priority 101 # 100 for BACKUP virtual_router_id 51 garp_master_delay 1

authentication { auth_type PASS auth_pass password } track_interface { eth0 } virtual_ipaddress { 172.16.100.1/16 dev eth0 label eth0:0 } track_script { chk_haproxy chk_mantaince_down }

notify_master "/etc/keepalived/notify.sh master" notify_backup "/etc/keepalived/notify.sh backup" notify_fault "/etc/keepalived/notify.sh fault" }

注意:1、上面的state为当前节点的起始状态,通常在master/slave的双节点模型中,其一个默认为MASTER,而别一个默认为BACKUP。2、priority为当关节点在当前虚拟路由器中的优先级,master的优先级应该大于slave的;其中global_defs表示全局模式,vrrp_instance用来定义虚拟路由组的。3、提供notify.sh脚本#!/bin/bash# vip=172.16.100.1contact='root@localhost'Notify() { mailsubject="`hostname` to be $1: $vip floating" mailbody="`date '+%F %H:%M:%S'`: vrrp transition, `hostname` changed to be $1" echo $mailbody | mail -s "$mailsubject" $contact}case "$1" in master) notify master /etc/rc.d/init.d/haproxy start exit 0 ;; backup) notify backup /etc/rc.d/init.d/haproxy restart exit 0 ;; fault) notify fault exit 0 ;; *) echo 'Usage: `basename $0` {master|backup|fault}' exit 1 ;;esac 4、安装HAProxy tar xf haproxy-1.4.20.tar.gz cd haproxy-1.4.20 make TARGET=linux26PREFIX=/usr/local/haproxy install cd /usr/local/haproxy/ mkdir conf logs cd conf/ vim haproxy.cfg /usr/local/haproxy/sbin/haproxy-f /usr/local/haproxy/conf/haproxy.cfg

haproxy.cfg ============= global log127.0.0.1 local3 info maxconn4096 #单个进程的最大并发连接数 usernobody groupnobody daemon#进程在后台运行 nbproc1 #创建一个进程 pidfile/usr/local/haproxy/logs/haproxy.pid defaults maxconn2000 #最大连接数 contimeout5000 #连接超时 clitimeout30000 #客户端超时 srvtimeout30000 #服务器超时 modehttp #http 7层模式 logglobal log127.0.0.1 local3 info statsuri /admin?stats #统计页面url optionforwardfor #后端服务器获取用户IP listen web0.0.0.0:80 modehttp statsenable balanceroundrobin #负载均衡的方式 cookieSERVERID insert indirect nocache #客户端的cookie信息 optionhttpclose #每次请求完毕后主动关闭http通道 optionforwardfor optionhttpchk HEAD /index.html HTTP/1.0 #健康检查 serverserver1 1.1.1.10:80 cookie 1 check inter 2000rise 2 fall 5 serverserver2 1.1.1.20:80 cookie 2 check inter 2000rise 2 fall 5 #cookie 1 标识serverid为 1 #check inter 2000检测心跳频率 #rise 2 2次正确认为服务器可用 #fall 5 5次失败认为服务器不可用 5、测试负载均衡效果以及高可用性 负载均衡测试:启动真实服务器的web服务,在2个真实服务器上创建2个首页文件,内容分别为test1和test2,如果在浏览器上访问web服务每次刷新既显示test1又显示tetst2就说明负载均衡已经生效了.6、高可用性测试:拔掉主调度服务器的网线或者关闭主调度服务器,看下VIP是否顺利的切换到从调度器,假如切换正常,那就说明keepalived已经成功生效了

|