|

|

Hadoop The Definitive Guide 2nd Edition是我读的关于hadoop的第一本书,对于处于新手阶段的我,这本书对我的帮助很大,这本书从hadoop的起源开始逐步讲解hadoop,可能是因为作者也是hadoop项目中的一个成员吧,对于hadoop讲解的十分到位。好记性不如烂笔头,今天开始做些笔记,方便日后查看。

第一章主要介绍了Hadoop的起源和一些其他分布式系统的比较,也介绍了hadoop的发展事记。现在随着云计算的发展,hadoop异常火爆,就拿我这段时间应聘的公司来说,不管是知名的互联网企业还是国企研究所,基本上每个公司都会有类似的描述“熟悉海量数据处理者优先,熟悉Hadoop类系统者优先”,可见Hadoop确实很实用。这也是我为什么将学习hadoop来作为学习云计算的第一步。

第二章简单的介绍了hadoop中mapreduce的基本概念和工作原理,并用一个气象数据分析的例子来说明。关于这个例子的数据可以从ftp://ftp.ncdc.noaa.gov/pub/data/gsod/下载。观察下载的数据,发现格式有个很大的变化,所以必须修改书上的程序才能得到正确的结果。修改方法如下:

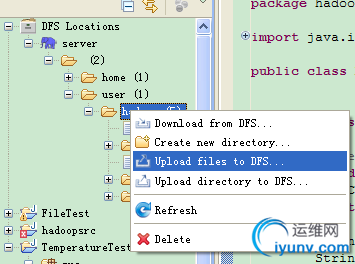

将下载数据解压,选择一个文件作为输入来进行测试,文件的第一行不是数据,所以要删除,将文件名字改成1.txt,上传到HDFS中,可以用eclipse直接上传:

编写mapper和reducer:

package hadoop.chapter2;

import java.io.IOException;

import org.apache.hadoop.io.DoubleWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

public class MaxTemperatureMapper

extends Mapper<LongWritable, Text, Text, DoubleWritable> {

private static final double MISSING = 99.9;

@Override

protected void map(LongWritable key, Text value,

Context context)

throws IOException, InterruptedException {

String line = value.toString();

String year = line.substring(14, 18);

double airTemperature = Double.parseDouble(line.substring(104, 108));

if (airTemperature != MISSING) {

context.write(new Text(year), new DoubleWritable(airTemperature));

}

}

}

package hadoop.chapter2;

import java.io.IOException;

import org.apache.hadoop.io.DoubleWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

public class MaxTemperatureReducer

extends Reducer<Text, DoubleWritable, Text, DoubleWritable> {

@Override

protected void reduce(Text key, Iterable<DoubleWritable> values,

Context context)

throws IOException, InterruptedException {

double maxValue = Double.MIN_VALUE;

for (DoubleWritable value : values) {

maxValue = Math.max(maxValue, value.get());

}

context.write(key, new DoubleWritable(maxValue));

}

}

package hadoop.chapter2;

import java.io.IOException;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.DoubleWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

public class MaxTemperature {

public static void main(String[] args) {

if (args.length != 2) {

System.err.println("参数错误");

System.exit(-1);

}

try {

Job job = new Job();

job.setJarByClass(MaxTemperature.class);

FileInputFormat.addInputPath(job, new Path(args[0]));

FileOutputFormat.setOutputPath(job, new Path(args[1]));

job.setMapperClass(MaxTemperatureMapper.class);

job.setReducerClass(MaxTemperatureReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(DoubleWritable.class);

job.waitForCompletion(true);

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (InterruptedException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} catch (ClassNotFoundException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

代码编写完了,就可以运行了。首先要修改运行参数:

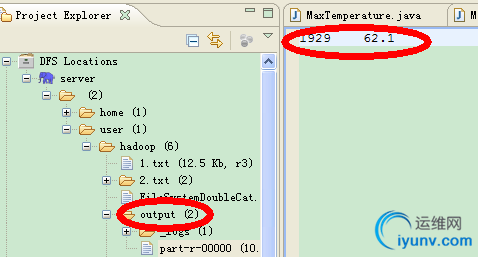

然后就可以运行拉,运行之后的结果会保存在output中,我们查看一下:

之后介绍了mapreduce分布化的工作过程:

先了解一些基本概念:

Job:客户端的执行单位,它包括输入数据、MapReduce程序和配置信息。

Task:Hadoop将输入数据分解成若干个Split,然后针对每个Split进行MapReduce操作,针对每一个split的操作称为一个task。

JobTracker:MapReduce系统的大脑,调度任务在tasktracker上执行。

TaskTracker:干活的小弟,负责task的执行,并将进度报告给老大JobTracker。

Hadoop将输入数据分解成split,然后为每个split创建一个map任务,在taskttracke上执行。Split分片的大小默认是64MB,是跟HDFS默认块大小相等。这样规定两者相等并不是巧合,而是考虑到数据处理局部行优化。就是说尽量保证每一个map任务执行所需要的数据存储在本地,这样数据的读取就不用通过网络传输,不但提高处理速度,而且降低整个系统的网络负载。如果Split的大小大于HDFS块大小,那么会以两个或多个快的形式存放在HDFS中,对于一个HDFS节点来说,基本不可能同时存放着两个块,因此必须通过网络传输获得所有的输入数据。

map任务将结果写到本地磁盘,并不存储在HDFS中,这是因为map的结果是中间结果,如果存到HDFS中,会复制成三份,对于中间结果没有必要这样做。

reduce任务的数量不是由输入数据决定的,而是人为制定的。

有多个reducer的情况下,每一个map的结果默认会按key进行分区和排序,分区的数量当然是等于reducer的数量,如果定义了combiner函数,会执行combiner函数对map的结果进行合并,map任务结束后,不同的分区会传送到不同的reducer上,这就是混洗的过程。

第二章其他内容是介绍不同的编程语言和与hadoop交互了,比如ruby,C++,python等,这部分我并不是很关心,没仔细看,以后用到在查,呵呵,好了前两章的笔记就是这样了:) |

|