Hadoop的核心就是HDFS与MapReduce

HDFS(Hadoop Distributed File System)由GFS(Google File System)演变而来,用于管理数据存储。

MapReduce 是一个分布式计算框架,用于数据分析处理。

1. HDFS

HDFS采用master/slave的架构,对应分别是Namenode 和Datanode

master/slave : Namenode,Datanode

Namenode:Namenode执行文件系统的名字空间操作,比如打开、关闭、重命名文件或目录。它也负责确定数据块到具体Datanode节点的映射。

Datanode:Datanode负责处理文件系统客户端的读写请求。在Namenode的统一调度下进行数据块的创建、删除和复制。

文件怎么存的?

文件分块,存到Datanode里。分块的原则:除了最后一个数据块,其它数据块的大小相同,一般为64MB or 128MB。

每个数据块有副本(一般为3):副本多了浪费空间。

副本存储:在大多数情况下,副本系数是3,HDFS的存放策略是将一个副本存放在本地机架的节点上,一个副本放在同一机架的另一个节点上,

最后一个副本放在不同机架的节点上。这种策略减少了机架间的数据传输,这就提高了写操作的效率。

副本目的:可靠性+性能

集群中单一Namenode的结构大大简化了系统的架构。Namenode是所有HDFS元数据的仲裁者和管理者,这样,用户数据永远不会流过Namenode。

client读数据:为了降低整体的带宽消耗和读取延时,HDFS会尽量让读取程序读取离它最近的副本。如果在读取程序的同一个机架上有一个副本,

那么就读取该副本。如果一个HDFS集群跨越多个数据中心,那么客户端也将首先读本地数据中心的副本。

client写数据:一次性写入,多次读取,数据访问会高效。

通讯协议:tcp/ip

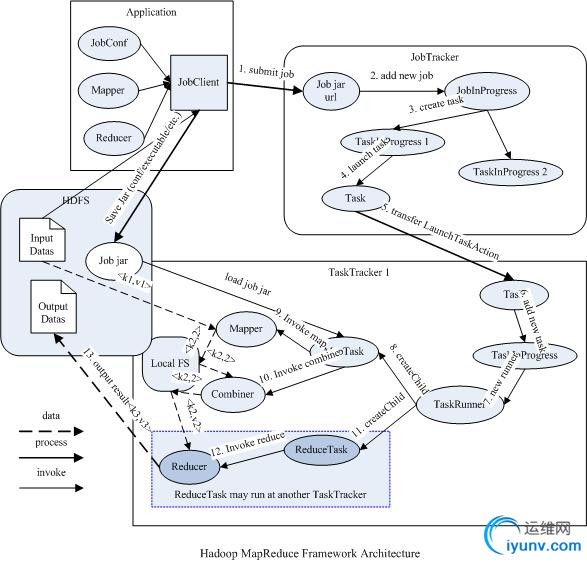

2. MapReduce

流程:

Inputformat——》map——》(combine)——》partition——》copy&merge——》sort——》reduce——》outputformat

优化措施:合理设计MapReduce, 代码级别

转载一篇讲的比较好的文章:

我们以wordcount为例,假设有个6400M的文件,100台hadoop机器(准确地说应该是tasktracker机),默认block大小为64M,这样每台执行map的文件刚好是一个64M的block文件(假设这个分发过程已经完成,同时忽略备份数之类的细节),并且我们使用10个reduce任务来归并文件。Hadoop的mapreducer的执行过程如下:

这100台机器上面的map都是并发、独立的执行,以wordcount为例,步骤如下:

1、<wbr>每个map任务使用默认的textinputformat类的LineRecordReader方法按行读取文件,这个读取的行数据就被交给map函数去执行,wordcount的map做的就是提取里面的单词,并以单词为key,1为value作为输出,格式为:<word integer(1)>。</wbr>

2、<wbr>如果有combine,先对第一步的输出结果就行combine操作。Combine就是个小reduce操作,作用就是对某个map自己的输出结果先进行一次归并,把相同word的计数累加,这样假设某个map输出结果做如果有50%的重复word,那combine后的中间结果大小可以减少一半,可减少后续的patition、copy、sort等的开销,提高性能。</wbr>

3、<wbr>每个map对自己的输出文件进行patition操作。上面提到有10个reducer任务,那默认的patition操作就是对map的输出kay进行hash,并对10求余(hash(key)),并提供10个文件(内存足够的话可以是链表等内存数据结构),假设是r1、r2….r10这10个文件,把不同key的放到不同的文件,这次操作就可以把相同key聚合到同一个文件。由于算法一样,保证了每个map的输出结果经过这个操作后,相同key的肯定在同一个聚合文件里,比如某个单词word肯定都在r1文件里。</wbr>

4、<wbr>接下来就是copy文件的过程了,10个reducer任务各自从所有map机器上取到属于自己的文件,比如reducer1会从100台map机器上取到所有r1文件,reducer2取所有r2的文件,这样同一类word已经到了同一台reducer机器上了。</wbr>

5、<wbr>每个reducer合并(meger)自己取到的文件,reducer1就是合并100个r1文件(实际过程是在上面第4步操作中会边copy边meger,在内存中)。</wbr>

6、<wbr>合并好后进行下sort(排序)操作,再次把不同小文件中的同一个单词聚合在一起。作为提供给reduce操作的数据。</wbr>

7、<wbr>进行reduce操作,对同一个单词的value列表再次进行累加,最终得到某个单词的词频数。</wbr>

8、<wbr>Outputformat操作,把reduce结果写到磁盘。</wbr>

所以,总的流程应该是这样的:

*<wbr><wbr>Inputformat——》map——》(combine)——》partition——》copy&merge——》sort——》reduce——》outputformat</wbr></wbr>

由此我们也可以看出,执行reduce的代价还是有些的,所以如果我们的应用只使用map就能搞定的话,那就尽量不要再有reduce操作在其中。

3. Hadoop调度流程

|