|

|

复制:两种架构

1、一个master(读写),多个slave(读),但是mongodb这种架构无法实现故障自动转移

2、副本集:

复制集、副本集:Replicaset,至少三个节点,通过选举选出1个主节点和2个备节点。主节点负责读写,备节点监控主节点并从主节点上获得其心跳信息。万一主节点挂了,则剩下的节点通过选举选出新的主节点,备节点则自动将其主节点指向新的主节点。能实现自动故障转移。在实现复制时,必须指明处于哪个副本集,所有节点都要明确工作于某个副本之上,只在此副本实现主从架构。如果还有其他节点,但其他节点所处的集群名称不一样的话,就处于不同的复制架构中。集群名称通过副本集名称定义的。主节点将所有的写操作写在一个日志文件(oplog)中,从节点复制写操作并在本地执行一遍。这个复制是异步的。

还有一种情况:

三个节点中有一个节点不存任何数据,只有选举权,而没有被选举权。这样会导致假如一个节点挂了后,剩下的一个节点没有从节点,这样那个活动节点要降级为只读模式,因为它无法保证数据有副本存放的。

副本集参数:

replset:副本集名称

oplogsize:日志大小

fastsync:快速同步

replindexprefetch:在实现复制时,根据索引实现数据预取。这种特性可以实现快速装载主节点上的数据,尤其在修改量比较大的集群上,非常有意义,在2.2.2版本实现

实验:

条件:

所有节点时间同步

配置文件中的集群名称一致

三个节点都安装mongodb

三个节点的/etc/hosts文件设置如下:

三个节点都创建数据目录、更改属主属组、修改配置文件请看上文

配置文件最后加上:

rest = true 显示按钮的相关信息

复制配置文件到另外两个节点:

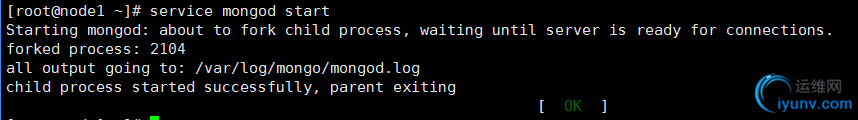

启动服务:(三个节点都启动)

连接到任意节点执行副本集初始化命令即可。(rs命令)

rs.status:显示rs状态

rs.initiate:初始化,第一次实现创建副本集要用这个命令初始化

rs.initiate(cfg):通过配置文件来初始化,配置文件由下面的命令获得

rs.conf:获取配置文件

rs.reconfig(cfg):重新初始化

rs.add(hostportstr):添加从节点的端口号

rs.add(membercfgobj):添加从节点

初始化:

查看状态:

查看是否为主节点:

添加从节点并查看信息:

testrs0:PRIMARY> rs.add("192.168.0.22:27017")

{ "ok" : 1 }

testrs0:PRIMARY> rs.status()

{

"set" : "testrs0",

"date" : ISODate("2016-11-29T14:25:50Z"),

"myState" : 1,

"members" : [

{

"_id" : 0,

"name" : "node1:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 557,

"optime" : Timestamp(1480429519, 1),

"optimeDate" : ISODate("2016-11-29T14:25:19Z"),

"self" : true

},

{

"_id" : 1,

"name" : "192.168.0.22:27017",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 31,

"optime" : Timestamp(1480429519, 1),

"optimeDate" : ISODate("2016-11-29T14:25:19Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:25:49Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:25:50Z"),

"pingMs" : 0,

"syncingTo" : "node1:27017"

}

],

"ok" : 1

}

添加第二个节点并查看状态:(不知为何会不一样)

testrs0:PRIMARY> rs.add("192.168.0.23:27017")

{ "down" : [ "192.168.0.23:27017" ], "ok" : 1 }

testrs0:PRIMARY> rs.status()

{

"set" : "testrs0",

"date" : ISODate("2016-11-29T14:28:05Z"),

"myState" : 1,

"members" : [

{

"_id" : 0,

"name" : "node1:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 692,

"optime" : Timestamp(1480429663, 1),

"optimeDate" : ISODate("2016-11-29T14:27:43Z"),

"self" : true

},

{

"_id" : 1,

"name" : "192.168.0.22:27017",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 166,

"optime" : Timestamp(1480429663, 1),

"optimeDate" : ISODate("2016-11-29T14:27:43Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:28:04Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:28:04Z"),

"pingMs" : 0,

"syncingTo" : "node1:27017"

},

{

"_id" : 2,

"name" : "192.168.0.23:27017",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 22,

"optime" : Timestamp(1480429663, 1),

"optimeDate" : ISODate("2016-11-29T14:27:43Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:28:03Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:28:04Z"),

"pingMs" : 2,

"syncingTo" : "node1:27017"

}

],

"ok" : 1

}

查看master:

在主节点创建数据,看从能否获取到

主节点:

testrs0:PRIMARY> use testdb

switched to db testdb

testrs0:PRIMARY> db.testcoll.insert({Name:'test',Age:50,Gender:'F'})

testrs0:PRIMARY> db.testcoll.find({Name:'test'})

{ "_id" : ObjectId("583d92d63b539fcc9aef4fd4"), "Name" : "test", "Age" : 50, "Gender" : "F"

从节点:

从节点不能直接查询的,必须使用rs.slaveOk()把自己提升为可以接受查询的从节点

testrs0:SECONDARY> rs.slaveOk()

testrs0:SECONDARY> use testdb

switched to db testdb

testrs0:SECONDARY> db.testcoll.find({Name:'test'})

{ "_id" : ObjectId("583d92d63b539fcc9aef4fd4"), "Name" : "test", "Age" : 50, "Gender" : "F" }

让主节点挂点,看是否有一个会提升为主的:

停止主节点的服务即可:

[root@node1 ~]# service mongod stop

Stopping mongod: [ OK ]

在刚才的备节点查看状态:

testrs0:SECONDARY> rs.status()

{

"set" : "testrs0",

"date" : ISODate("2016-11-29T14:45:20Z"),

"myState" : 1,

"members" : [

{

"_id" : 0,

"name" : "node1:27017",

"health" : 0,

"state" : 8,

"stateStr" : "(not reachable/healthy)",

"uptime" : 0,

"optime" : Timestamp(1480430294, 1),

"optimeDate" : ISODate("2016-11-29T14:38:14Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:45:19Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:44:00Z"),

"pingMs" : 0

},

{

"_id" : 1,

"name" : "192.168.0.22:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 1210,

"optime" : Timestamp(1480430294, 1),

"optimeDate" : ISODate("2016-11-29T14:38:14Z"),

"self" : true

},

{

"_id" : 2,

"name" : "192.168.0.23:27017",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 1056,

"optime" : Timestamp(1480430294, 1),

"optimeDate" : ISODate("2016-11-29T14:38:14Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:45:19Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:45:19Z"),

"pingMs" : 1,

"lastHeartbeatMessage" : "syncing to: 192.168.0.22:27017",

"syncingTo" : "192.168.0.22:27017"

}

],

"ok" : 1

}

testrs0:PRIMARY> #这里已经改为主的了

在新的主节点添加数据:

然后在从节点查看:

让之前的主节点从新上线:

testrs0:PRIMARY> rs.status()

{

"set" : "testrs0",

"date" : ISODate("2016-11-29T14:50:31Z"),

"myState" : 1,

"members" : [

{

"_id" : 0,

"name" : "node1:27017",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY", #其状态不再是主的了

"uptime" : 45,

"optime" : Timestamp(1480430874, 1),

"optimeDate" : ISODate("2016-11-29T14:47:54Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:50:30Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:50:29Z"),

"pingMs" : 1,

"lastHeartbeatMessage" : "syncing to: 192.168.0.22:27017",

"syncingTo" : "192.168.0.22:27017"

},

{

"_id" : 1,

"name" : "192.168.0.22:27017",

"health" : 1,

"state" : 1,

"stateStr" : "PRIMARY",

"uptime" : 1521,

"optime" : Timestamp(1480430874, 1),

"optimeDate" : ISODate("2016-11-29T14:47:54Z"),

"self" : true

},

{

"_id" : 2,

"name" : "192.168.0.23:27017",

"health" : 1,

"state" : 2,

"stateStr" : "SECONDARY",

"uptime" : 1367,

"optime" : Timestamp(1480430874, 1),

"optimeDate" : ISODate("2016-11-29T14:47:54Z"),

"lastHeartbeat" : ISODate("2016-11-29T14:50:29Z"),

"lastHeartbeatRecv" : ISODate("2016-11-29T14:50:29Z"),

"pingMs" : 1,

"syncingTo" : "192.168.0.22:27017"

}

],

"ok" : 1

}

打印复制信息:

配置优先级:

rs.conf()显示现有的配置

testrs0:SECONDARY> rs.conf()

{

"_id" : "testrs0",

"version" : 3,

"members" : [

{

"_id" : 0,

"host" : "node1:27017"

},

{

"_id" : 1,

"host" : "192.168.0.22:27017"

},

{

"_id" : 2,

"host" : "192.168.0.23:27017"

}

]

}

编辑配置文件:

方式1:rs.conf({id:xxx}),这种方式比较麻烦

方式2:把内容保存到文件中,重新应用就可以了

cfg=rs.conf()保存文件

cfg.members[0].priority=2设置优先级

rs.reconfig(cfg)重新应用

只能在主节点进行配置:

40-45从看

三个节点理由有一个可以不被选举,只参与选举,无法触发选举,但可以参与选举。这种节点的优先级为0

触发重新选举:

一个几点只能以从节点的身份去上线,然后主节点主持重新选举。

优先级为0的节点:无权触发,仅参与选举

添加优先级为0的节点:rs.addArb(hostportstr)

移除节点:rs.remove(hostportstr)

Sharding:把一个很大的表的数据切割后放到不同的节点,各节点只存放一部分。每个服务器成为一个sharding节点。把每个collection分割为多片,平均分配到各节点。均匀分配。

用途:

复制集很大、吞吐量大

高并发查询可能耗尽cpu的处理能力

海量数据集超出某一个节点的存储能力

降低单台服务器的io压力

sharding架构:

config servers:存储元数据

shard:存储数据

读操作:请求过来了,app server先去查找元数据,再查找shard。性能不好,因为各索引在shard节点中

写操作:shard特长

shard必须和业务数据相关联。

生产环境中应该至少有三个config server节点,这些服务器压力很小,所以可以放到运行其他应用的节点

mongos:端口28017,用来接收用户请求,合并数据,扮演前段的代理服务器。router之间不会通信。mongos1个也可以,mongos也可以直接安装到应用服务器中

shard:至少有2个

实验:1个mongos,1个config server,2个shard

1、配置config server

2、配置mongos

3、配置shard

配置config server:192.168.0.22

保存退出,重启服务

端口:

配置mongos:

启动shard:

只需改下数据目录,重启服务即可

下图中的A为主shard:

连接mongos:

查看shard状态:

添加shard:在192.168.0.22上添加

使用分区功能:sh.enableSharding(dbname)

collection支持分区功能:sh.shardCollection(fullName,key,unique)

添加数据:

在mongos上查看分片:192.168.0.21

完成重新均衡:

sh.addShard(host)添加新的shade

sh.setBalancerState均衡

查看是否均衡:

补充:

php访问mongodb,需要编译相应的驱动。

aubiter:仅参与选举,不持有任何数据

0优先级的节点:持有数据,参与选举,但不能成为主节点

shard:

读:不离散

写:离散

选择sharding key的标准:

应该在哪里存储数据

应该从哪里得到希望的数据

基本法则:

sharding key应该是主键

sharding key应该能尽量保证避免跨分片查询

自学:

1、新增shard

2、移除shard

命令:

mongodump:备份

mongorestore:恢复

mongoexport:导出

mongoimport:导入

mongostat:监控

mongotop:

mongooplog:

mongoperf:性能评估

mongofiles:查看和修改GridFS文件系统

|

|