|

|

一、实验环境

服务器

| IP地址

| 安装软件 | | tomcatA | 172.16.8.1 | apache-tomcat-7.0.42 | | tomcatB | 172.16.8.3 | apache-tomcat-7.0.42 | apache

| 172.16.8.2 | httpd-2.4.9 |

此实验是基于上篇博客来进行的http://584014981.blog.51cto.com/8605371/1414644 ,这里只需要安装配置下tomcatB,(tomcat安装步骤不在演示),然后修改下tomcatB的站点目录文件。内容如下:

# vim /web/webapp/index.jsp

//添加如下:

TomcatB

TomcatB

Session ID

Created on

启动测试:

二、负载均衡实现

两种方式都能实现负载均衡:

- 基于mod_proxy模块实现负载均衡

- 基于mod_jk模块实现负载均衡

下面我们就来分别演示一下,

1.基于mod_proxy实现负载均衡

[root@localhost ~]# vim /etc/httpd/httpd.conf

//修改如下:

Include /etc/httpd/extra/httpd-proxy.conf //启用此配置文件

#Include /etc/httpd/extra/httpd-jk.conf //禁用此配置文件

[root@localhost ~]# vim /etc/httpd/extra/httpd-proxy.conf

//修改如下:

BalancerMember ajp://172.16.8.1:8009 loadfactor=1 route=TomcatA //采用ajp协议,权重为1

BalancerMember ajp://172.16.8.3:8009 loadfactor=1 route=TomcatB

ProxySet lbmethod=bytraffic

ProxyVia on

ProxyRequests Off

ServerName www.gulong.com

ProxyPass / balancer://lbcluster/

ProxyPa***everse / balancer://lbcluster/

Require all granted

Require all granted

[root@localhost ~]# service httpd restart

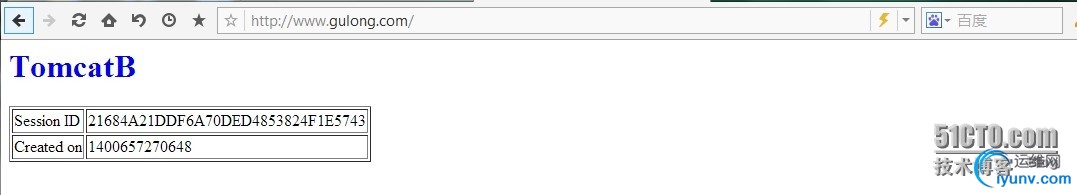

从图看出,负载均衡已经实验成功(注:如果要用域名访问,在hosts文件中写入 172.16.8.2 www.gulong.com)

从图看出,负载均衡已经实验成功(注:如果要用域名访问,在hosts文件中写入 172.16.8.2 www.gulong.com)

2、基于mod_jk模块实现负载均衡

说明:

为了避免用户直接访问后端Tomcat实例,影响负载均衡的效果,建议在Tomcat 7的各实例上禁用HTTP/1.1连接器。

为每一个Tomcat 7实例的引擎添加jvmRoute参数,并通过其为当前引擎设置全局惟一标识符。如下所示。需要注意的是,每一个实例的jvmRoute的值均不能相同。

[root@localhost bin]# vim /usr/local/tomcat/conf/server.xml //tomcatA修改

[root@localhost bin]# vim /usr/local/tomcat/conf/server.xml //tomcatB修改

[root@localhost bin]# service tomcat restart //重启各个节点的tomcat

1、修改httpd配置文件

[root@localhost ~]# vim /etc/httpd/httpd.conf

//修改如下:

#Include /etc/httpd/extra/httpd-proxy.conf //禁用此配置文件

Include /etc/httpd/extra/httpd-jk.conf //启用此配置文件

2、修改/etc/httpd/extra/workers.properties

[root@localhost ~]# vim /etc/httpd/extra/workers.properties

worker.list = lbcluster,stat1 //列表信息

worker.TomcatA.type = ajp13 //支持ajp协议

worker.TomcatA.host = 172.16.8.1 //TomcatA实例IP

worker.TomcatA.port = 8009 //TomcatA实例端口号

worker.TomcatA.lbfactor = 1 //负载均衡权重为1

worker.TomcatB.type = ajp13

worker.TomcatB.host = 172.16.8.3

worker.TomcatB.port = 8009

worker.TomcatB.lbfactor = 1

worker.lbcluster.type = lb //负载均衡work,lb内置的类

worker.lbcluster.sticky_session = 0 //会话是否绑定

worker.lbcluster.balance_workers = TomcatA, TomcatB //TomcatA, TomcatB 集群中的实列

worker.stat1.type = status //状态信息

3、修改/etc/httpd/extra/httpd-jk.conf

[root@localhost ~]# vim /etc/httpd/extra/httpd-jk.conf

//修改如下:

LoadModule jk_module modules/mod_jk.so //加载mod_jk模块

JkWorkersFile /etc/httpd/extra/workers.properties //配置文件位置

JkLogFile logs/mod_jk.log //日志

JkLogLevel debug //日志级别

JkMount /* lbcluster //修改负载均衡器名称

JkMount /jkstatus/ stat1 //状态信息

[root@localhost ~]# service httpd restart

三、DeltaManager实现

我们发现上面在实验的时候,访问同一站点,session id一直在变,不能保持,这种现象是非常不好的,比如当我们访问一个购物网站时,我们在购物车里添加了一些商品,当我们一刷新网页,因为采用了负载均衡,可能就会转到另一台tomcat服务器上,而我们的会话又没有保持,因此购物车里商品会消失掉,这对购物网站来说是非常糟糕的状况!因此我们需要实现会话保持!

1.会话管理

种类:

(1).标准会话管理器(StandardManager):

默认保存于$CATALINA_HOME/work/Catalina///下的SESSIONS.ser文件中。

maxActiveSessions:最多允许的活动会话数量,默认为-1,表示不限制;

maxInactiveInterval:非活动的会话超时时长,默认为60s;

pathname:会话文件的保存目录;

(2).持久会话管理器(PersistentManager):

将会话数据保存至持久存储中,并且能在服务器意外中止后重新启动时重新加载这些会话信息。持久会话管理器支持将会话保存至文件存储(FileStore)或JDBC存储(JDBCStore)中。

保存至文件中的示例:

每个用户的会话会被保存至directory指定的目录中的文件中,文件名为.session,并通过后台线程每隔一段时间(checkInterval参数定义,默认为60秒)检查一次超时会话。

保存至JDBCStore中的示例:

2.Manager组件

Manger对象用于实现HTTP会话管理的功能,Tomcat中有5种Manger的实现:

(1).StandardManager

Tomcat6的默认会话管理器,用于非集群环境中对单个处于运行状态的Tomcat实例会话进行管理。当Tomcat关闭时,这些会话相关的数据会被写入磁盘上的一个名叫SESSION.ser的文件,并在Tomcat下次启动时读取此文件。

(2).PersistentManager

当一个会话长时间处于空闲状态时会被写入到swap会话对象,这对于内存资源比较吃紧的应用环境来说比较有用。

(3).DeltaManager

用于Tomcat集群的会话管理器,它通过将改变了会话数据同步给集群中的其它节点实现会话复制。这种实现会将所有会话的改变同步给集群中的每一个节点,也是在集群环境中用得最多的一种实现方式。

(4).BackupManager

用于Tomcat集群的会话管理器,与DeltaManager不同的是,某节点会话的改变只会同步给集群中的另一个而非所有节点。

(5).SimpleTcpReplicationManager

Tomcat4时用到的版本,过于老旧了。

3.DeltaManager具体实现过程

(1).修改server.xml配置文件

tomcatA:

[root@localhost WEB-INF]# vim /usr/local/tomcat/conf/server.xml

//在Engine组件内增加下面这一长段代码

tomcatB:

[root@node1 WEB-INF]# vim /usr/local/tomcat/conf/server.xml

//同样的在Engine组件内增加下面这一长段代码

(2).修改web.xml

tomcatA:

[root@node1 ~]# cd /web/webapp/

[root@node1 webapp]# ls

index.jsp

[root@node1 webapp]# mkdir WEB-INF

[root@node1 webapp]# ls

index.jsp WEB-INF

[root@node1 webapp]# cp /usr/local/tomcat/conf/web.xml WEB-INF/

[root@node1 ~]# vim /usr/local/tomcat/conf/web.xml

tomcatB:

[root@localhost ~]# cd /web/webapp/

[root@localhost webapp]# ls

index.jsp

[root@localhost webapp]# mkdir WEB-INF

[root@localhost webapp]# ls

index.jsp WEB-INF

[root@localhost webapp]# cp /usr/local/tomcat/conf/web.xml WEB-INF/

[root@localhost ~]# vim /usr/local/tomcat/conf/web.xml

(3)、在各节点为使用组播地址添加组播路由

tomcatA:

[root@localhost WEB-INF]# route add -net 228.0.0.8 netmask 255.255.255.255 dev eth0

tomcatB:

[root@node1 WEB-INF]# route add -net 228.0.0.8 netmask 255.255.255.255 dev eth0

(4)、各节点重启tomcat,测试

#service tomcat restart

从上图看出,不管你怎么刷新SessionID都不会变,说明我们的Tomcat的DeltaManager集群配置完成,实现了多台主机之间会话共享,会话保持成功!

|

|

|

|

|

|

|

|

|