概述

session的作用

httpd是无状态协议,多个http请求之间是没有关联的,服务器端也无法识别哪些请求来自同一个客户端。为了解决这一问题,当客户端第一次访问时,服务器端会创建一个session来保存这一次的会话信息,然后将sessionID(session的唯一标识符)放置在响应报文的首部发送给客户端,客户端再次请求时会携带这个sessionID(通常在request的cookie中)表示这属于哪一个会话。

维持session的方式

在Tomcat实现负载均衡后,客户端的请求会被调度至不同的服务器,session信息往往保存在其中一台服务器的内存中,若之后的请求被调度至其他的服务器上,则客户端无法访问到之前的session信息。解决这一问题的方式有3种:

1)session绑定,在调度时,将同一个客户端的请求始终调度至同一台服务器;

2)session集群,将多台服务器上的session信息实时进行同步;

3)session服务器,将所有服务器上的session信息都存放至session服务器。

第一种方式可以在前端的代理服务器上配置相应的参数实现,但是这种方式会影响负载均衡的效果,并且其中的一台服务器故障了,其上的session信息也会全部丢失。第二种方式通过同步session实现,即每一个会话的session信息存在于所有的服务器上,这个不适用于大型的集群环境。第三种方式是将session信息集中存放至一台专用的服务器上,例如memcache服务器上,服务器在处理请求时会首先将session信息从memcache同步至本地,然后进行处理。本文介绍第二种和第三种的实现方式。

session集群的实现

实验环境:2个tomcat节点,利用httpd实现负载均衡。

192.168.1.116 #http服务器

192.168.1.106 #tomcat node1

192.168.1.127 #tomcat node2

1)首先配置http服务器实现负载均衡(192.168.1.116上)。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

| [iyunv@www ~]# vim /etc/httpd/extra/httpd-vhosts.conf

#######全局配置端################

<proxy balancer://lbcluster>

BalancerMember http://192.168.1.106:8080 loadfactor=1 route=a

BalancerMember http://192.168.1.127:8080 loadfactor=1 route=b

#ProxySet stickysession=JSESSIONID #不做session绑定

ProxySet lbmethod=bytraffic

</proxy>

########虚拟主机的配置##############

<VirtualHost *:80>

ServerName www.xiaoxiao.com

ProxyVia Off

ProxyRequests Off

ProxyPreserveHost On

ProxyPass / balancer://lbcluster/

ProxyPassReverse / balancer://lbcluster/

<Location /status>

SetHandler balancer-manager

Proxypass !

Require all granted

</Location>

<Proxy *>

Require all granted

</Proxy>

<Location / >

Require all granted

</Location>

</VirtualHost>

|

包含对应文件:

1

2

3

| [iyunv@www ~]# vim /etc/httpd/httpd.conf

........

Include /etc/httpd/extra/httpd-vhosts.conf

|

2)在每个tomcat节点上配置server.xml文件,在需要实现session集群的host中添加如下段落,若以下内容定义在Engine容器中,则表示所有主机均启用集群功能。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

| [iyunv@node1 ~]# vim /usr/local/tomcat/conf/server.xml

.....

<Cluster className="org.apache.catalina.ha.tcp.SimpleTcpCluster"

channelSendOptions="8">

<Manager className="org.apache.catalina.ha.session.DeltaManager"

expireSessionsOnShutdown="false"

notifyListenersOnReplication="true"/>

<Channel className="org.apache.catalina.tribes.group.GroupChannel">

<Membership className="org.apache.catalina.tribes.membership.McastService"

address="228.0.3.4"

port="45564"

expireSessionsOnShutdown="false"

notifyListenersOnReplication="true"/>

<Channel className="org.apache.catalina.tribes.group.GroupChannel">

<Membership className="org.apache.catalina.tribes.membership.McastService"

address="228.0.3.4" #监听的多播地址(最好不要使用默认值)

port="45564" #监听的端口

frequency="500" #每个多长时间发一次心跳信息(单位毫秒)

dropTime="3000"/> #超时时长(超过这个时间还没有接受到心跳信息,则从Membership中移除该成员)

<Receiver className="org.apache.catalina.tribes.transport.nio.NioReceiver"

address="192.168.1.106" #通过哪个接口接收数据,如果有多个IP地址,这里需要指定

port="4000"

autoBind="100"

selectorTimeout="5000"

maxThreads="6"/>

<Sender className="org.apache.catalina.tribes.transport.ReplicationTransmitter">

<Transport className="org.apache.catalina.tribes.transport.nio.PooledParallelSender"/>

</Sender>

<Interceptor className="org.apache.catalina.tribes.group.interceptors.TcpFailureDetector"/>

<Interceptor className="org.apache.catalina.tribes.group.interceptors.MessageDispatch15Interceptor"/>

</Channel>

<Valve className="org.apache.catalina.ha.tcp.ReplicationValve"

filter=""/>

<Valve className="org.apache.catalina.ha.session.JvmRouteBinderValve"/>

<Deployer className="org.apache.catalina.ha.deploy.FarmWarDeployer"

tempDir="/tmp/war-temp/"

deployDir="/tmp/war-deploy/"

watchDir="/tmp/war-listen/"

watchEnabled="false"/>

<ClusterListener className="org.apache.catalina.ha.session.JvmRouteSessionIDBinderListener"/>

<ClusterListener className="org.apache.catalina.ha.session.ClusterSessionListener"/>

</Cluster>

.....

|

若在虚拟机中配置必须指定Receiver段中的address为本机上某接口的地址。在node2节点上配置时,将该参数改为对应的IP地址(192.168.1.127)。

3)为期望实现集群功能的webapp的web.xml文件添加<distributable/>

1

2

3

4

5

6

| [iyunv@node1 web]# vim WEB-INF/web.xml

.....

<web-app .....

.....

<distributable/>

</web-app>

|

4)在tomcat的两个节点上添加测试页面

node1上(192.168.1.106):

1

2

3

4

5

6

7

8

9

10

11

| [iyunv@node1 ~]# vim /tomcat/webapps/web/index.jsp

<%@ page language="java" %>

<html>

<head><title>Tomcat node1</title></head>

<body>

<h1><font color="blue">Tomcat node1</font></h1></p>

<% session.setAttribute("xiaoxiao.com","xiaoxiao.com"); %>

<h4>Session_ID:<%= session.getId() %></h4></p>

<h4>Creat_time:<%= session.getCreationTime() %></h4></p>

</body>

</html>

|

node2上(192.168.1.127):

1

2

3

4

5

6

7

8

9

10

11

| [iyunv@node2 ~]# vim /tomcat/webapps/web/index.jsp

<%@ page language="java" %>

<html>

<head><title>Tomcat node2</title></head>

<body>

<h1><font color="red">Tomcat node2</font></h1></p>

<% session.setAttribute("xiaoxiao.com","xiaoxiao.com"); %>

<h4>Session_ID:<%= session.getId() %></h4></p>

<h4>Creat_time:<%= session.getCreationTime() %></h4></p>

</body>

</html>

|

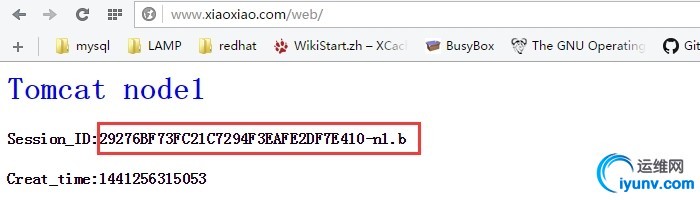

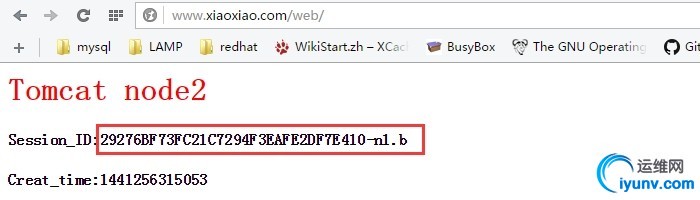

最后重启tomcat服务,进行测试:

调度至不同的节点上,session信息没有发上变化,测试完成。

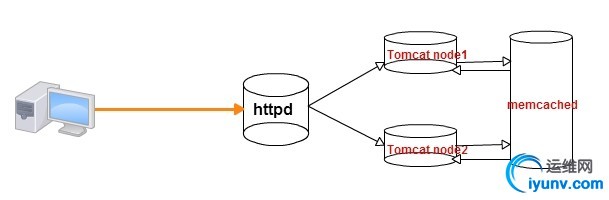

基于memcached+MSM实现session服务器

实验拓扑

实验环境:

192.168.1.116 #http服务器

192.168.1.106 #tomcat node1 192.168.1.127 #tomcat node2 192.168.1.121,192.168.1.122 #memcached服务器

工作原理:

用户第一次访问时,服务器端会创建会话信息,保存在进程中,实时同步至memcache,若下一次调度至其他节点上,该节点首先会检查自己的会话区域,若没有这个用户的会话,就去memcache中找这个会话信息,然后将这个会话信息从memcache读到自己的web container中,若会话更新也会立刻同步至memcache中。之后同一个客户端的某一次请求调度至之前访问过的节点,该节点会先去memcache中检查本地的会话信息是否和memcache上的同步,如果不同步从memcache读取新数据覆盖自己的原有数据。

memcached-session-manager(msm)为Google提供的一款工具,能够实现将tomcat会话信息保存至memcache中,并在需要时将对应信息读入web container。它可以工作在两种模式下:1)会话有粘性,2)会话无粘性,即前端的代理服务器是否启用了stickysession(同一客户端请求代理至同一服务器)。上述的工作原理是工作在会话无粘性的模式下,若在会话有粘性的场景中,当用户来访问时,就不需要每次去memcache中检查会话信息是不是最新的,会话更新后,也不需要将会话信息及时同步至memcache中,可以节约一些步骤和带宽。

memcached-session-manager的下载地址,http://code.google.com/p/memcached-session-manager/,该项目基于Java开发,需要使用如下的jar文件(version版本号):

memcached-session-manager-version.jar

memcached-session-manager-tc(6|7|8)-version.jar

spymemcached-version.jar

msm-javolution-serializer-version.jar

javolution-version.jar

其中msm-javolution-serializer为一款流式化工具,能够将会话信息转成流式数据存放在memcache上,在读取时再将其还原,类似的工具有很多,在实现过程中可以根据需要选择不同的流式化工具。相关的配置也不同,参考官方文档即可。

实现过程

1)在192.168.1.121,192.168.1.122上安装memcached

1

2

3

4

5

6

7

8

9

10

11

| [iyunv@node1 ~]# tar xf libevent-2.0.21-stable.tar.gz

[iyunv@node1 ~]# cd libevent-2.0.21

[iyunv@node1 ~]# ./configure --prefix=/usr/local/libevent

[iyunv@node1 ~]# make && make install

[iyunv@node1 ~]# echo "/usr/local/libevent/lib" > /etc/ld.so.conf.d/libevent.conf

[iyunv@node1 ~]# ldconfig

#####################################################

[iyunv@node1 ~]# tar xf memcached-1.4.15.tar.gz

[iyunv@node1 ~]# cd memcached-1.4.15

[iyunv@node1 ~]# ./configure --prefix=/usr/local/memcached --with-libevent=/usr/local/libevent

[iyunv@node1 ~]# make && make install

|

为memcached提供服务脚本,并配置为系统服务(脚本可以copy得到)

1

2

3

| [iyunv@node1 ~]# chmod +x /etc/init.d/memcached

[iyunv@node1 ~]# chkconfig --add memcached

[iyunv@node1 ~]# service memcached start

|

2)在tomcat node1和node2节点上添加虚拟主机(会话无粘性的模式下):

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

| [iyunv@node1 ~]# vim /usr/local/tomcat/conf/server.xml

........

<Host name="www.xiaoxiao.com" appBase="/tomcat/webapps"

unpackWARs="true" autoDeploy="true">

<Context path="/web" docBase="web" reloadable="true">

<Manager className="de.javakaffee.web.msm.MemcachedBackupSessionManager"

memcachedNodes="n1:192.168.1.121:11211,n2:192.168.1.122:11211"

sticky="false"

sessionBackupAsync="false"

lockingMode="uriPattern:/path1|/path2"

requestUriIgnorePattern=".*\.(ico|png|gif|jpg|css|js)$"

transcoderFactoryClass="de.javakaffee.web.msm.serializer.javolution.JavolutionTranscoderFactory"

/>

</Context>

</Host>

|

会话有粘性的模式下:

1

2

3

4

5

6

7

8

9

10

11

12

13

| [iyunv@node1 ~]# vim /usr/local/tomcat/conf/server.xml

........

<Host name="www.xiaoxiao.com" appBase="/tomcat/webapps"

unpackWARs="true" autoDeploy="true">

<Context path="/web" docBase="web" reloadable="true">

<Manager className="de.javakaffee.web.msm.MemcachedBackupSessionManager"

memcachedNodes="n1:192.168.1.121:11211,n2:192.168.1.122:11211"

failoverNodes="n1"

requestUriIgnorePattern=".*\.(ico|png|gif|jpg|css|js)$"

transcoderFactoryClass="de.javakaffee.web.msm.serializer.javolution.JavolutionTranscoderFactory"

/>

</Context>

</Host>

|

memcachedNodes指定后端的memcache服务器地址和端口,这里使用了两个memcache服务器,目的是起到高可用的作用。在保存session信息时需要同时写到两个memcache服务器上。

3)将需要的jar文件(类库)复制到tomcat的lib目录下:

1

2

3

4

| [iyunv@node1 msm]# ls

javolution-5.5.1.jar memcached-session-manager-tc7-1.8.2.jar spymemcached-2.10.2.jar

memcached-session-manager-1.8.2.jar msm-javolution-serializer-1.8.2.jar

[iyunv@node1 msm]# cp ./* /usr/local/tomcat/lib/

|

复制到另外一个节点:

1

| [iyunv@node1 msm]# scp ./* 192.168.1.127:/usr/local/tomcat/lib/

|

然后重启两个节点上的tomcat服务:

1

| [iyunv@node1 ~]# service tomcat restart

|

利用上一个案例配置的负载均衡和添加的测试页面进行测试,测试结果与上述一致。.................^_^

|